U Sjedinjenim Američkim Državama dogodio se presedan koji je izazvao veliku pažnju javnosti i otvorio pitanje granica digitalne privatnosti. Po prvi put, američke vlasti su zatražile od kompanije OpenAI, kreatora ChatGPT-a, da otkrije identitet jednog korisnika, čiji su razgovori postali deo istrage o dečjoj pornografiji na dark webu.

Ovaj zahtev je stigao od Ministarstva za unutrašnju bezbednost SAD, odnosno njihove istražne službe (HSI), i predstavlja prvi poznati slučaj u kojem je neka državna agencija formalno tražila podatke o konkretnim ChatGPT razgovorima.

Kako je sve počelo

Istraga je započela pokušajem identifikacije administratora velike dark web platforme koja je distribuirala zabranjene materijale. Tokom tajnog kontakta sa osumnjičenim, istražitelji su primetili da on često koristi ChatGPT i da je sam pomenuo koje je upite unosio – od potpuno bezazlenih, poput „Šta bi se desilo da se Šerlok Holms sretne sa Q-om iz Zvezdanih staza“, do šaljivih pesama u stilu Donalda Trampa.

Upravo su ovi detalji omogućili agentima da od suda zatraže nalog kojim bi OpenAI bio obavezan da dostavi podatke o tom nalogu – ime i prezime, adresu, informacije o plaćanju, istoriju razgovora i metapodatke o korišćenju platforme.

Kompanija OpenAI je, prema izveštajima, dostavila tražene informacije u vidu Excel datoteke, iako sadržaj tog dokumenta nije javno objavljen.

Presedan koji menja digitalnu bezbednost

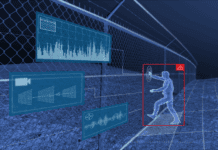

Ovo je prvi slučaj u kojem su podaci iz razgovora sa veštačkom inteligencijom korišćeni u zvaničnoj istrazi, što otvara pitanje koliko su zapravo privatni naši online razgovori i do koje mere tehnološke kompanije moraju sarađivati sa državnim institucijama.

Time je otvorena nova era digitalne bezbednosti u kojoj granica između korisničke privatnosti i zakonske obaveze saradnje sa vlastima postaje sve nejasnija.

Reakcija OpenAI-a

Prema zvaničnim podacima, OpenAI je samo u drugoj polovini 2024. godine detektovao više od 31.000 slučajeva sadržaja koji se odnosi na eksploataciju dece i prosledio ih američkom Nacionalnom centru za nestalu i eksploatisanu decu (NCMEC). U istom periodu kompanija je primila 71 zvaničan zahtev od državnih organa, što je rezultiralo davanjem podataka o 132 naloga.

Ovaj slučaj jasno pokazuje da generativna veštačka inteligencija, poput ChatGPT-a, više nije samo alat za komunikaciju ili pomoć u radu, već potencijalno i izvor obaveštajnih i istražnih podataka.

Granica između bezbednosti i zloupotrebe

I dok jedni smatraju da je saradnja AI sistema sa vlastima opravdana kada se radi o suzbijanju najtežih oblika kriminala, drugi upozoravaju da takva praksa može postati opasno oružje nadzora.

Postavlja se pitanje: – „Ako veštačka inteligencija može sarađivati sa vlastima i davati podatke o korisnicima, gde je granica zaštite privatnosti?“

I još važnije: – „Ako generativna AI može da kreira sadržaj koji deluje realno, može li u nekom trenutku “izmisliti“ podatke i dovesti do pogrešnih zaključaka, a na taj način i do hapšenja nevinih ljudi?“

U eri u kojoj veštačka inteligencija sve više učestvuje u sferama bezbednosti, pravo postavlja se pravo pitanje – Ko kontroliše istinu kada algoritmi postanu svedoci?