Kako AI oblikuje budućnost krivičnog prava?

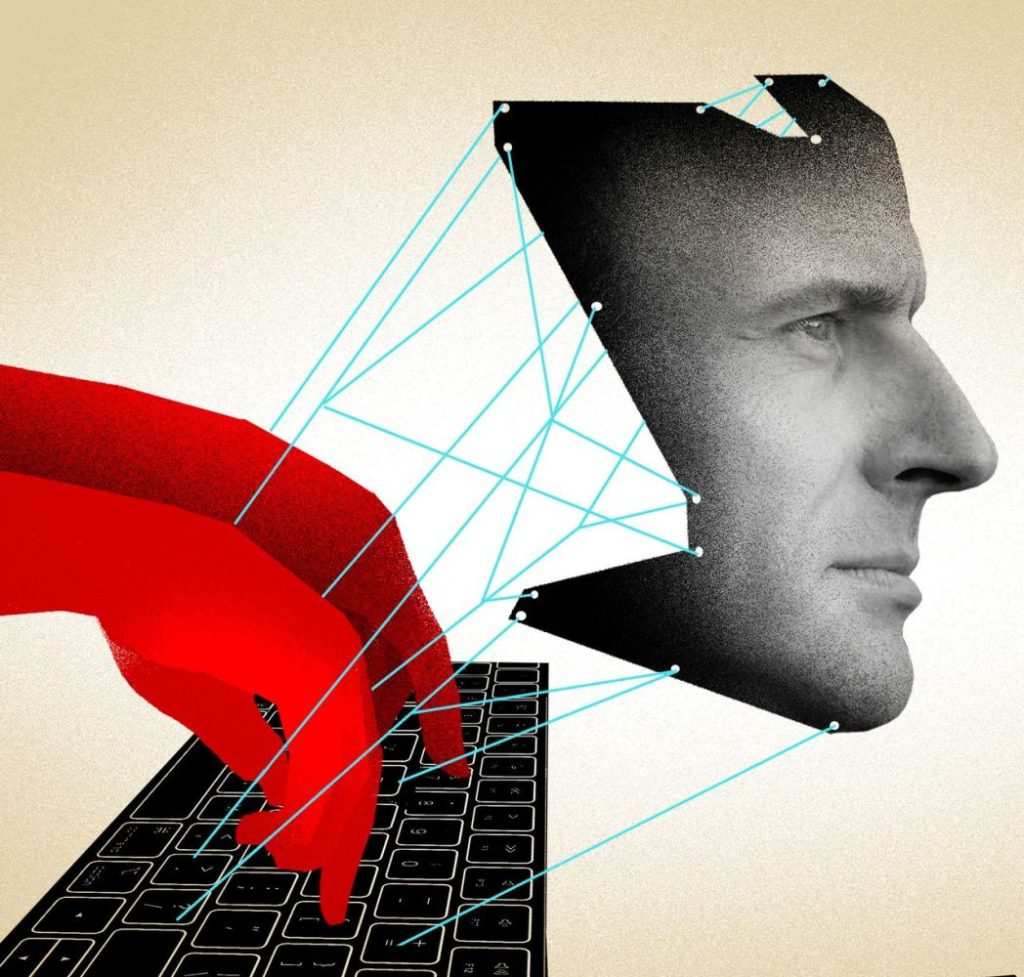

U poslednjih nekoliko godina, rapidan razvoj veštačke inteligencije (AI) donosi brojne inovacije, ali i izazove, posebno u domenu pravosuđa. Jedno od gorućih pitanja jeste odgovornost za krivična dela koja nisu počinjena, ali se prikazuju kao stvarna uz pomoć generativne veštačke inteligencije, poznatije kao ‘deep fake’ tehnologija.

Upozorenje na potencijalne opasnosti

Elon Musk, poznat po revolucionarnim idejama u različitim industrijskim sektorima, više puta je izrazio zabrinutost zbog potencijalnih opasnosti koje AI nosi. Posebno je istakao rizik od stvaranja „besmrtnog diktatora“, odnosno AI sistema koji bi mogao imati nekontrolisani uticaj i doslovno potlačiti čovečanstvo. Ovo postavlja osnovu za buduće pravne dileme vezane za AI tehnologije, naročito u kontekstu krivičnih dela i falsifikovanih dokaza.

„Bako, NISAM JA na telefonu!“ – Kloniranje glasova u službi prevara i iznuda

Od diskriminacije do zloupotrebe

Već od osamdesetih godina, etički problemi vezani za AI bili su vidljivi, kao što je diskriminacija žena i kandidata sa „neevropskim“ prezimenima pri odabiru studenata. Danas, ovi problemi su se proširili i uključuju potencijalno ugrožavanje života i ljudskih prava, kao i manipulaciju ponašanjem, posebno kod dece i mladih.

Generativna veštačka inteligencija, sposobna za stvaranje realističnih slika, tonova ili video zapisa, otvara vrata za nove vrste zloupotreba.

Lažne optužbe

U današnjem svetu veštačke inteligencije (AI), suočavamo se sa sve većim rizikom od lažnih optužbi, što naglašava stručnjak Denis Parganlija. Postoji opasnost da kroz korišćenje AI-a nenamerno nanosimo štetu nevinim osobama. On ukazuje na trenutni problem diskriminacije i pristrasnosti u primenama veštačke inteligencije, što može već sada dovesti do nepravednih optužbi.

Uz to, razvoj generativne veštačke inteligencije, koja može stvoriti realistične slike, tonove ili video zapise, dodatno povećava ovaj rizik.

Primer ovoga je nedavno objavljen video gde je Albert Ajnštajn, koji je preminuo 1955. godine, prikazan kako najavljuje kurs na Harvardu 2020. godine, koristeći njegovu sliku i tuđi glas. „Ovakav način produkcije omogućava stvaranje bilo čije slike u bilo kojem okruženju, što pokazuje koliko je tehnologija napredovala, ali i koliko je podložna zloupotrebi“, ističe Parganlija.

On upozorava na važnost opreza pri deljenju ličnih podataka na društvenim mrežama, uključujući slike, tonove i video zapise, zbog mogućnosti njihove zloupotrebe u svrhu kreiranja lažnih dokaza i optužbi.

Zakonsko uređenje AI i budući izazovi

Stručnjaci ističu potrebu za zakonskim predviđanjem i sankcionisanjem zloupotreba veštačke inteligencije (AI), kao i drugih tehnologija. Ovo ne isključuje podršku razvoju AI unutar zakonskih okvira, ali zahteva jasno definisane uslove pod kojima se može verovati AI aplikacijama, imajući u vidu da nijedna nije savršena. Pouzdanost AI je ključna za njenu praktičnu upotrebu.

Trenutno, zakonsko uređenje AI tehnologija je u početnoj fazi, kako u Evropi tako i globalno. Evropska unija je u završnoj fazi usvajanja Uredbe o veštačkoj inteligenciji koja se bavi transparentnošću i otpornošću na manipulaciju u AI sistemima. Međutim, tehnološki napredak često nadmašuje zakonodavne procese, što stvara dodatne izazove.

Posebno zabrinjavajuće su optužbe zasnovane na lažnim dokazima kreiranim pomoću generativne veštačke inteligencije, poput ‘deep fake’ tehnologije. U takvim slučajevima, neophodna je stručna procena da bi se utvrdilo da li je materijal autentičan ili falsifikovan, pri čemu se i sama AI može koristiti za ovu vrstu analize.

Denis Parganlija, stručnjak u ovom polju, upozorava na složenost AI sistema i mogućnost da se unutar njihovih algoritama skrivaju manipulativni podalgoritmi, što može rezultirati neočekivanim i potencijalno opasnim ishodima. Kao primer navodi situaciju u kojoj AI aplikacija, poput ChatGPT-a, može biti obmanuta da prihvati i širi etički ili zakonski neprihvatljive informacije.

Parganlija naglašava da AI aplikacije moraju biti dizajnirane tako da budu otporne na manipulacije i sposobne da razlikuju pouzdane od nepouzdanih informacija. Takve aplikacije bi mogle imati pozitivan uticaj i doneti značajne promene.

Iako trenutno nema poznatih sudskih slučajeva gde su odluke donete na osnovu neistinitih optužbi izvedenih iz AI, Parganlija napominje da pravni eksperti već razmatraju ovu mogućnost. Na primer, nedavni članak u Hastings Law Journal-u iz SAD-a poziva na veće ovlasti sudija u sprečavanju upotrebe falsifikovanih AI dokaza u sudskim procesima.

Rizik od zloupotrebe veštačke inteligencije raste sa tehnološkim napretkom, što je potvrdio i Europol upozoravajući na potencijalne opasnosti. Ovo ukazuje na urgentnu potrebu za pravnom regulativom koja bi pratila tehnološki razvoj i štitila pojedince od nepravednih optužbi zasnovanih na AI.

Da li će se uspostaviti ravnoteža između inovacija i zaštite?

Kako Denis Parganlija naglašava, veštačka inteligencija ima potencijal da donese brojne koristi, ali je ključno da njena upotreba bude u skladu s etičkim i zakonskim normama. Svi smo potencijalno na udaru AI-manipulacije, i stoga je važno osigurati da AI sistemi budu otporni na manipulaciju i pouzdani u svom radu. Informisanost, obrazovanje i adekvatna regulativa su ključni za efikasno snalaženje u ovom neistraženom području.